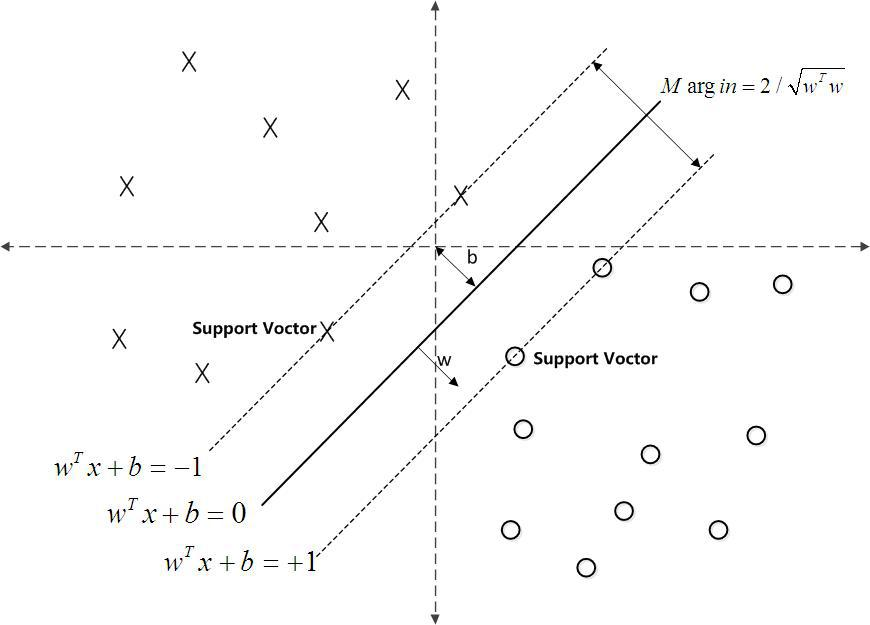

通俗来讲,它是一种二分类模型,其基本模型定义为特征空间上的间隔最大的线性分类器,其学习策略便是间隔最大化,最终可转化为一个凸二次规划问题的求解。

SVM

SVM的目标函数基本型

函数间隔和几何间隔,假设超平面为$w^Tx+b=0$:

函数间隔:

用$|w^Tx+b|$衡量点x到超平面的远近,若$w^Tx+b$的符号与类标记符号y一致,则分类正确。

因此可以用$y(w^Tx+b)$的正负性判断分类正确性。

定义函数间隔为$r=y(W^Tx+b)$

几何间隔:

点到超平面的距离为$\frac{|w^Tx+b|}{||w||}$

定义几何间隔为$r=\frac{y(w^Tx+b)}{||w||}$

因此,几何间隔实际上相当于函数间隔初上$||w||$

基本型中函数间隔取1,目标函数的最大化几何间隔$2/||w||$, 约束中要满足每个样本的函数间隔大于1.

预测函数模型

对偶问题

拉格朗日函数,即对每条约束添加拉格朗日乘子$\alpha_i\ge0$

对w和b求偏导为0后的结果代入基本型消除w和b, 就得到对偶问题。

max

根据对偶问题max求解$\alpha$

求解时要满足KKT条件:

支持向量

根据对偶问题求出$\alpha_i$,若$\alpha_i>0$, 则对应的样本为支持向量。训练完成后,大部分的样本不需要保留,模型只和支持向量有关。虚线间隔边界上的点就是支持向量。

非线性情况

解决非线性问题时,需要将原始样本映射到高维空间中,使得样本在高维空间中线性可分。

令映射函数为$\varphi$,则样本x映射后的向量变为$\varphi(x)$

同上:

基本型

然后根据基本型得到对偶问题并求解

预测函数模型

核函数

求解对偶问题时需要计算$\varphi(x_i)^T\varphi(x_j)$, 即样本$x_i, x_j$映射到高维空间后的内积,计算困难。因此可以设想一个函数,满足:

这个函数$\kappa()$即核函数,使得$x_i, x_j$的内积变换后等价于高维空间的内积,减少了计算量。

要求:只要一个对称函数所对应的核矩阵半正定,就能作为核函数。

软间隔

在基本型中要求所有样本满足约束条件(函数间隔大于1)称为硬间隔;

在软间隔中允许部分样本不满足约束条件;

作用是为了避免在高维空间中仍然无法线性可分的情况和过拟合的情况;

替代损失函数:Hinge loss; 指数损失;对率损失;

若采用hinge损失,目标函数基本型变为(其中C为无穷大时则相当于硬间隔):

$min\frac{1}{2}w^2+C\sum_{i=1}^{m}max(0, (1-y_i(w^Tx_i+b))$

引入松弛变量$\xi_i=max(0, (1-y_i(w^Tx_i+b))$, 因此约束中$\xi_i\ge(1-y_i(w^Tx_i+b))$, 得到:

$s.t. y_i(w^Tx_i+b)\ge1-\xi_i, i=1,2,…,m$

$\xi_i\ge0$

SVR支持向量回归

目标回归模型

传统回归模型计算损失:计算模型输出f(x)和真实输出y之间的差别作为损失,当且仅当f(x)和y相同时损失为0;

SVR计算损失:允许存在偏差$\epsilon$, 仅当f(x)和y之间的差别大于偏差时才开始计算损失,即以f(x)为中心,构建了宽度为2ε的间隔带,当训练样本落入此间隔带,则认为预测正确。

基本型

其中$l_\epsilon(z)$函数即为了满足间隔带要求,当$|z|<\epsilon$时损失为0, 否则损失为$|z|-\epsilon$

类似于加正则项的线性回归,只不过计算损失函数的方式不同。

为什么要把原问题转换为对偶问题?

因为原问题是凸二次规划问题,转换为对偶问题更加高效。

为什么求解对偶问题更加高效?

因为只用求解alpha系数,而alpha系数只有支持向量才非0,其他全部为0.

alpha系数有多少个?

样本点的个数

参考:

周志华,机器学习:SVM

图形解释,知乎:https://www.zhihu.com/question/21094489

支持向量机通俗解释,CSDN: http://blog.csdn.net/v_july_v/article/details/7624837

支持向量机通俗导论,july: https://blog.csdn.net/v_july_v/article/details/7624837